In diesem Artikel beleuchten wir, was Token sind und wie sie berechnet werden. Des Weiteren geben wir ein konkretes Beispiel für ihre Verwendung und bieten Tipps zur effizienten Einsparung von Token.

- Definition von Token

- Wie Token berechnet werden

- Ein Beispiel für Token

- Ein Vergleich zwischen Wort- und Subword-Tokenisierung

- Effiziente Nutzung von Token

Definition von Token

Token sind ein zentraler Baustein in der Textverarbeitung von maschinellen Lernmodellen wie OpenAI’s ChatGPT und bilden die Grundlage für das Verständnis und die Interpretation von Textdaten. Diese Elemente, auch als Token bezeichnet, sind die kleinsten Einheiten, die solche Modelle verarbeiten können.

In der einfachsten Form kann ein Token ein einzelnes Wort, ein Satzzeichen oder ein Leerzeichen darstellen. Komplexere Modelle wie ChatGPT erweitern dieses Konzept jedoch und können Token auch als Teile eines Wortes oder sogar mehrere Wörter definieren. Dieser Ansatz wird als Subword-Tokenisierung bezeichnet.

Wie Token berechnet werden

Bei der Verarbeitung eines Textes wird dieser zunächst in eine Reihe von Token zerlegt. Dieser Vorgang wird Tokenisierung genannt. Das Modell verwendet dann die repräsentativen Zahlenwerte dieser Token zur Analyse und Vorhersage des Textes.

Ein wichtiger Aspekt dabei ist die Begrenzung der Anzahl der Token, die ein Modell verarbeiten kann. Bei GPT-3.5 Turbo liegt diese Grenze beispielsweise bei 4.096 Token und bei GPT-4 bei 8.192 Token. Diese Begrenzung betrifft sowohl die Eingabe- als auch die Ausgabetexte und wird auch als Kontextfenster bezeichnet. Die Anzahl der Token, die in einem Chat-Modell wie ChatGPT zugelassen werden, hängt nicht nur von den technischen Beschränkungen des Modells selbst ab, sondern kann auch vom Betreiber des Chats oder der spezifischen Anwendung festgelegt werden.

Ein Beispiel für Token

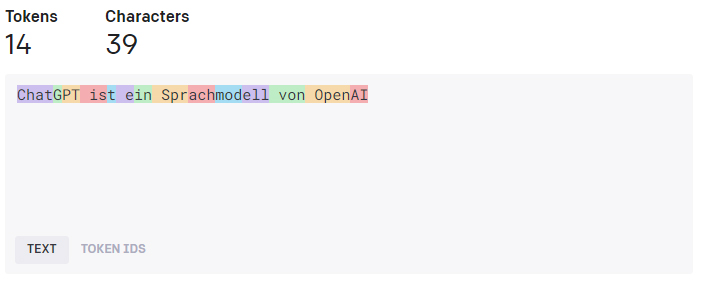

Ein Satz wie „ChatGPT ist ein Sprachmodell von OpenAI“ würde in einzelne Token zerlegt werden. In einer einfachen Wort-Tokenisierung könnte dieser Satz beispielsweise in folgende Token zerlegt werden:

Bei einer Subword-Tokenisierung könnte der gleiche Satz jedoch auch in mehr oder weniger Token zerlegt werden, abhängig von der spezifischen Tokenisierungslogik des Modells.

Ein Vergleich zwischen Wort- und Subword-Tokenisierung

Nehmen wir an, wir haben einen Text von 1000 Wörtern. In einer einfachen Wort-Tokenisierung hätten wir auch 1000 Token. In einer Subword-Tokenisierung könnte die Anzahl der Token jedoch variieren. Ein Wort wie „Konfiguration“ könnte beispielsweise in mehrere Token wie „Konfi“, „gura“, „tion“ zerlegt werden. Ebenso könnte ein Satzzeichen oder ein Leerzeichen auch als separates Token gezählt werden. Dies bedeutet, dass die Anzahl der Token höher sein könnte als die Anzahl der Wörter im Text.

Effiziente Nutzung von Token

Grundsätzlich gilt: Je weniger Text sowohl in der Frage als auch in der Antwort vorhanden ist, desto weniger Token werden verbraucht. Dies ist ein wichtiger Aspekt, den man bei der Verwendung von Modellen wie ChatGPT im Auge behalten sollte, um die Effizienz zu maximieren und die Nutzung der Token zu optimieren.

Effiziente Texteingabe: Versuchen Sie, Ihre Eingabe so prägnant und klar wie möglich zu gestalten. Unnötige Wiederholungen, übermäßig lange Sätze oder abschweifende Erläuterungen können die Anzahl der benötigten Token erhöhen.

Kürzere Antworten anfordern: In einigen Fällen können Sie die Länge der Antworten, die das Modell generiert, steuern. Kürzere Antworten bedeuten weniger Token.

Erinnerung an vorherige Nachrichten: Abhängig vom Anwendungsgebiet kann es sinnvoll sein, die Funktion zur Erinnerung an vorherige Nachrichten zu aktivieren oder zu deaktivieren. Diese Einstellung kann in ChatGPT-X unter „Einstellungen“ angepasst werden. Es ist wichtig zu beachten, dass bei aktivierter Funktion die Texte sowohl von vorherigen Fragen als auch Antworten zur Gesamtzahl der Token hinzugezählt werden, immer bezogen auf den jeweiligen Chat.

Aktivierung der Erinnerungsfunktion: Nehmen wir beispielsweise an, Sie nutzen ChatGPT zur Textzusammenfassung. Sie sind mit der ersten Zusammenfassung nicht zufrieden und geben einen weiteren Befehl zur Verbesserung des Textes. In diesem Fall wäre es sinnvoll, die Erinnerungsfunktion zu aktivieren. So kann der neue Befehl auf den Erkenntnissen des vorherigen aufbauen und eine verbesserte Zusammenfassung liefern. Dabei sparen Sie Token, da Sie den Ausgangstext nicht jedes Mal erneut eingeben müssen.

Deaktivierung der Erinnerungsfunktion: Angenommen, Sie verwenden ChatGPT, um eine Reihe thematisch völlig unabhängiger Gedichte zu generieren. In diesem Fall wäre es sinnvoll, die Erinnerungsfunktion zu deaktivieren. Auf diese Weise wird jede neue Aufforderung für ein Gedicht unabhängig von den vorherigen behandelt, was zu einzigartigen, unabhängigen Gedichten führt. Alternativ können Sie auch für jede Konversation einen neuen Chat starten, um sicherzustellen, dass vorherige Aufforderungen keinen Einfluss auf die neuen haben. Hierbei werden Token eingespart, da unnötige Texte, die keinen Zusammenhang mit der neuen Aufforderung haben, nicht hinzugezählt werden.